W ciągu ostatnich lat wiele osób zainwestowało spore środki w koparki kryptowalut. Ich podstawowym zadaniem było rozwiązywanie złożonych równań matematycznych w celu zatwierdzania transakcji w blockchainach, takich jak Bitcoin czy Ethereum. Jednak wraz ze zmianą algorytmów (np. przejściem Ethereum na Proof of Stake) oraz spadkiem opłacalności tradycyjnego kopania, coraz więcej osób zaczęło szukać alternatywnych zastosowań dla swojego sprzętu. Jednym z najbardziej obiecujących kierunków jest sztuczna inteligencja.

Dlaczego AI?

Sztuczna inteligencja, a w szczególności jej gałęzie takie jak uczenie maszynowe czy generatywne sieci neuronowe, wymagają ogromnej mocy obliczeniowej – dokładnie tej samej, którą oferują koparki GPU. Karty graficzne używane w rigach kopiących są zoptymalizowane do obliczeń równoległych, co czyni je idealnymi do trenowania modeli AI i przetwarzania danych w czasie rzeczywistym.

Zamiast więc porzucać lub sprzedawać sprzęt po niskiej cenie, można go z powodzeniem zaadaptować do nowej roli: pracy dla sieci sztucznej inteligencji.

Co można robić z koparką GPU w AI?

W zależności od konfiguracji i dostępnych zasobów, koparka może realizować różne zadania:

- Trenowanie modeli AI (np. sieci neuronowe, modele językowe, rozpoznawanie obrazów)

- Generowanie grafiki i wideo (np. AI-art, deepfake, image-to-image)

- Synteza mowy i muzyki

- Przetwarzanie języka naturalnego

- Zdalna praca jako węzeł obliczeniowy w rozproszonych sieciach AI (tzw. decentralized AI computing)

Jak przyłączyć koparkę do sieci AI?

Podobnie jak w przypadku kopania kryptowalut, wiele projektów AI wykorzystuje zdecentralizowane sieci, do których można się podłączyć i użyczać swojej mocy obliczeniowej w zamian za wynagrodzenie lub dostęp do wyników obliczeń. Oto krok po kroku, jak podłączyć koparkę do jednej z takich sieci:

1. Ocena sprzętu

Na początek warto sprawdzić, jakie karty graficzne są zainstalowane w Twojej koparce. Najlepiej sprawdzają się jednostki od NVIDII z dużą ilością pamięci VRAM (8 GB i więcej). Modele takie jak RTX 2060, 3060, 3080 czy nawet starsze 1660 Super nadal mają potencjał w projektach AI.

2. Wybór sieci lub projektu AI

Na rynku funkcjonuje już kilka zdecentralizowanych sieci AI, które przyjmują zewnętrzne GPU do swoich obliczeń. Niektóre z nich przypominają mining poole, ale zamiast haszowania, pracują nad zadaniami AI. Można też samemu hostować lokalne zadania (np. stable diffusion, RVC, whisper) i udostępniać je przez API.

3. Instalacja systemu operacyjnego i sterowników

Najczęściej stosowanymi systemami są Linux (np. Ubuntu Server) lub Windows. Dla AI rekomenduje się Linuxa z dobrze skonfigurowanym środowiskiem CUDA i cuDNN. Instalujemy sterowniki GPU i biblioteki do AI, takie jak:

- NVIDIA CUDA Toolkit

- cuDNN

- PyTorch lub TensorFlow

- Docker (opcjonalnie)

4. Instalacja i konfiguracja oprogramowania

W zależności od wybranej sieci AI, instalujemy odpowiedni agent – np. program, który łączy się z siecią i pobiera zadania do przetwarzania. Przykładowo:

- Bittensor (TAO) – zdecentralizowana sieć neuronowa, która nagradza za udział w trenowaniu modeli.

- Golem – sieć rozproszonej mocy obliczeniowej, pozwalająca na wykonywanie różnych zadań, w tym AI.

- O własny serwer AI – możesz uruchomić własne API do AI (np. Stable Diffusion WebUI, RVC, Whisper, Bark, OpenVoice) i oferować dostęp do zasobów GPU zdalnym klientom.

5. Monitorowanie i optymalizacja

Podobnie jak przy kopaniu, warto monitorować temperatury, zużycie energii, obciążenie GPU i RAM. Używając narzędzi takich jak nvidia-smi, Prometheus + Grafana, lub dedykowane aplikacje, można zapewnić maksymalną wydajność i stabilność działania.

6. Zarabianie na AI

Niektóre sieci wynagradzają w kryptowalutach (np. Bittensor płaci w TAO), inne oferują dostęp do usług lub tokenów. Można też oferować moc obliczeniową jako usługę (np. przez API, Discord bota lub stronę www). Wiele osób już teraz tworzy prywatne farmy AI, które nie tylko zarabiają, ale także przyspieszają ich własne projekty (np. deepfake, dubbing AI, analiza danych).

Podsumowanie

Era kopania kryptowalut powoli się kończy, ale era sztucznej inteligencji dopiero się zaczyna. Przekształcenie koparki GPU w węzeł obliczeniowy dla AI to nie tylko ekologiczne i ekonomiczne rozwiązanie, ale też szansa na uczestniczenie w technologicznej rewolucji. Warto zainteresować się tym już teraz, zanim sprzęt znowu zacznie się kurzyć w piwnicy.

Schemat działania – Jak koparka GPU pracuje w sieci AI

Oto uproszczony schemat:

Koparka GPU (rig z kartami NVIDIA)

|

v

System operacyjny (Linux/Windows)

|

v

CUDA + cuDNN + PyTorch/TensorFlow

|

v

Agent sieci AI (np. Bittensor, Golem)

|

v

Połączenie z siecią AI (peer-to-peer)

|

v

Zadania AI (np. trening modelu, generacja obrazu)

|

v

Wynik + nagroda (token, dostęp do usługi)

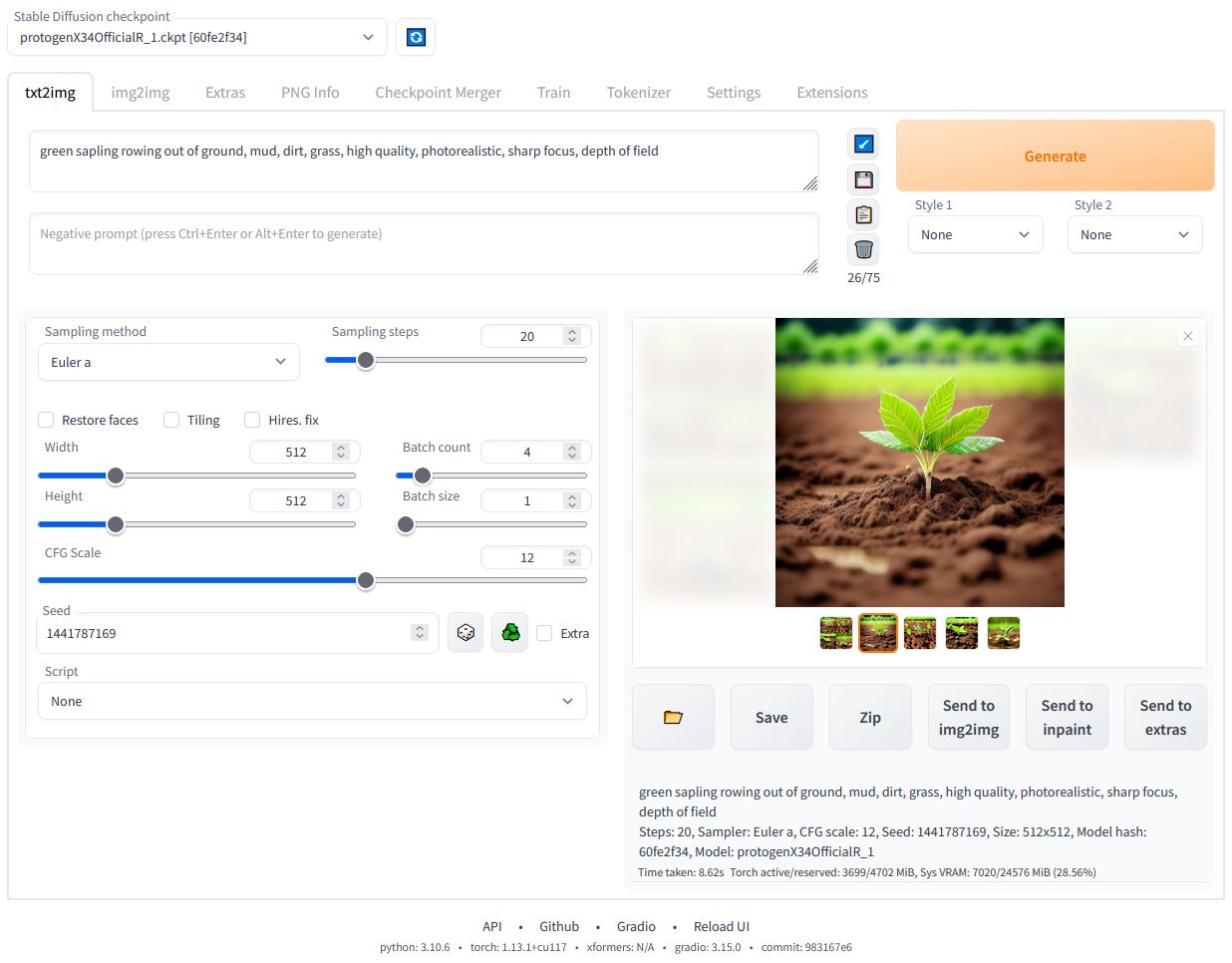

Zrzuty ekranu: Przykład konfiguracji koparki jako serwera Stable Diffusion

- Zainstalowane CUDA i sterowniki NVIDIA (Linux)

$ nvidia-smi

+-----------------------------------------------------------------------------+

| NVIDIA-SMI 525.105.17 Driver Version: 525.105.17 CUDA Version: 12.0 |

|-------------------------------+----------------------+----------------------+

| GPU Name Persistence-M| Bus-Id Disp.A | Volatile Uncorr. ECC |

| Fan Temp Perf Pwr:Usage/Cap| Memory-Usage | GPU-Util Compute M. |

+-------------------------------+----------------------+----------------------+

| 0 GeForce RTX 3060 Off | 00000000:01:00.0 Off | N/A |

| 30% 44C P8 17W / 170W | 0MiB / 12288MiB | 0% Default |

+-------------------------------+----------------------+----------------------+

- Stable Diffusion WebUI – interfejs uruchomiony lokalnie

Poradnik: Jak uruchomić Stable Diffusion WebUI na koparce GPU (Linux/Windows)

Krok 1 – Przygotowanie systemu

Zainstaluj:

- System: Ubuntu 22.04 LTS lub Windows 10/11

- Sterowniki NVIDIA + CUDA Toolkit

- Python 3.10+

- Git

Krok 2 – Klonowanie repozytorium

git clone https://github.com/AUTOMATIC1111/stable-diffusion-webui.git

cd stable-diffusion-webui

Krok 3 – Umieszczenie modelu

Pobierz plik modelu .ckpt lub .safetensors (np. v1-5-pruned-emaonly.ckpt) i wrzuć go do folderu models/Stable-diffusion/.

Krok 4 – Uruchomienie

./webui.sh # Linux

webui-user.bat # Windows

Interfejs będzie dostępny lokalnie pod adresem http://127.0.0.1:7860.

Możesz teraz używać swojej koparki jako lokalnej generatorki grafiki AI.

Bonus: Udostępnianie GPU przez sieć

Jeśli chcesz udostępniać zasoby zdalnie (np. znajomym albo klientom), możesz:

- Dodać proxy za pomocą ngrok lub Cloudflare Tunnel

- Zabezpieczyć dostęp loginem i hasłem

- Udostępnić API REST do generowania obrazów lub mowy

Przykład z Cloudflare Tunnel:

cloudflared tunnel --url http://127.0.0.1:7860